Ezzel a DH-val csak a baj van. Most se tudtam tőle több mint egy hétig posztolni. A viccet félretéve a mai bejegyzésem egyik apropója, hogy ősszel kell beadni az Alliance of Digital Humanities Organizations szokásos éves konferenciájára az absztraktokat, és miközben a sajátommal voltam elfoglalva, korábbiakat böngészgettem. Erről pedig az a kérdés jutott eszembe, hogy ez a terület hazánkban miért nincs külön kezelve, miért nincsenek DH-s események stb.

Pedig 1998-ban a fent említett szervezet épp Magyarországon rendezte meg a konferenciát a debreceni (akkor még) Kossuth Lajos Tudományegyetem közreműködésével. Az idei, a Stanfordon megrendezett konferencia anyagát áttekintve elámultam, milyen széles körben művelnek már digitális bölcsészettudományi tevékenységeket, valamint elgondolkodtam azon is, hogy nálunk miért nincs jelen egy-egy terület.

A majd egyhetes konferencián a szokásos előadásokon, posztereken kívül 7 félnapos tutorialt (ezt hogy kéne magyarul mondani?) és egy egésznapos workshopot (és ezt?) is tartottak a jelentkezőknek. Ezek között TEI-kódolással, a DH egyetemi oktatásba integrálásával, különböző konkrét szövegfeldolgozó eszközök (pl. Voyeur) használatával fogalalkozók stb. voltak. A (számomra) legizgalmasabbnak tűnő a Gabmap nevű projektet bemutató tutorial, amelynek során a résztvevők egy a nyelvi variancia elemzésésre alkalmas eszközt ismerhettek meg. A projekt elsősorban a dialektológia számára borzasztó érdekes, mert alkalmas arra, hogy a területi variációkat különböző szempontok szerint vizuálisan megjelenítva igen összetett elemzést hajtsunk végre. Egyébként az egésznapos workshop témája is a vizualizáció volt, és mostanában egyre többet lehet olvasni DH-s körökben arról az igényről, hogy az eredmények megismertetéséhez egyre több ilyen eszközt kellene fejleszteni.

A téma iránti felfokozott érdeklődést mutatja az is, hogy a keynote speaker (magyarul?), David Rumsey a történeti térképek digitalizálásáról és felhasználásáról tartott előadást. Az első napon délelőtt kétszer négy, délután egyszer négy szekcióban zajlottak az előadások, utána következett a poszterszekció. A délelőtti első szakasz panelje a virtuális városbemutató eszközökről, és ezek történelemtudományi hasznosításáról szólt. Vele párhuzamosan két klasszikus digitális filológiai kérdésekkel foglalkozó, valamint egy a digitális régészet- és történelemtudományi szekció zajlott. A számomra legérdekesebb előadások egy felhasználóközpontú digitális szótárról, a DH-s szerzőazonosításról, valamint a "számítógépes régészet"-ről szóltak.

A délelőtti második szakaszban hasonló felosztásban volt egy panel az általánosabb kultúra- illetve irodalomelméletről, két szekció kifejezetten NLP-s, illetve adatbányászati témájú volt, valamint egy szólt a multimédiás DH-s kérdésekről. A legérdekesebb előadások a középangol helyesírás probabilisztikus módszerekkel történő kezeléséről, a jelölőnyelvek és a gráfszerkezetek erejéről, hasznáról, valamint mangaképregények digitális képelemzéséről szóltak.

A délutáni részben volt egy borzasztó izgalmasnak tűnő panel, ahol az eseményközpontú történeti narratívák elemzésének a lehetőségeiről volt szó, és arról, hogy ebben hogyan működhet együtt a DH-s, az információs szakember és az számítástechnikus. (Ilyesmivel a Szegedi Egyetemen is foglalkoznak egyébként, lásd itt a projektek között.) A további három szekció összetétele számomra kicsit esetlegesnek tűnik, mert eléggé eltérő témájú előadások kerültek egymás mellé. Mindenesetre megtalálható volt itt crowdsourcingtól, a DH egyetemi oktatásán keresztül az adatbázisépítésig mindenféle téma.

A poszterszekció szerintem roppant érdekes lehetett. Olyan témák bukkanak itt föl, mint egy arab kéziratkorpusz fejlesztése, az R stilometriai alkalmazása, a homéroszi eposzok hang-n-gramjainak ábrázolása, történeti személyek és helynevek együttes előfordulásának ábrázolása, egyes eszközök (mint pl. a korábban már bemutatott TILE) fejlesztése és még sorolhatnánk.

A második előadásnapon az elsőhöz hasonlóan egy panel és három szekció zajlott párhuzamosan, három részletben. A kicsit vegyes szekciók mellett volt egy kifejezetten irodalomtudományi. A legérdekesebb előadások egy buddhizmussal kapcsolatos szótár digitális kiadásával, valamint egy kis DH-s tudományszociológiával foglalkoztak.

A délelőtt második felében a vegyes témájú szekciókon kívül volt ismét egy irodalmi (mégpedig 19. századi irodalommal foglalkozó), valamint egy eszközfejlesztéssel kapcsolatos szekció. Számomra a 19. századi novellák nemzeti jellegét feltárni kívánó projektet, valamint a TILE fejlesztését bemutató előadások tűnnek a legizgalmasabbnak.

A délutáni szekciók közül egynek volt határozottab arculata: ott konkrét projekteket mutattak be. Ezek közül talán az egyházi kanonikus citációk ontológiáját bemutató előadás lehetett a legérdekesebb. A vegyesek közül a különböző textuális információk vizualizációját lehetővé tévő program, valamint a különböző glifavariációk kezelését végző eszközt bemutató előadásokra ültem volna be elsősorban.

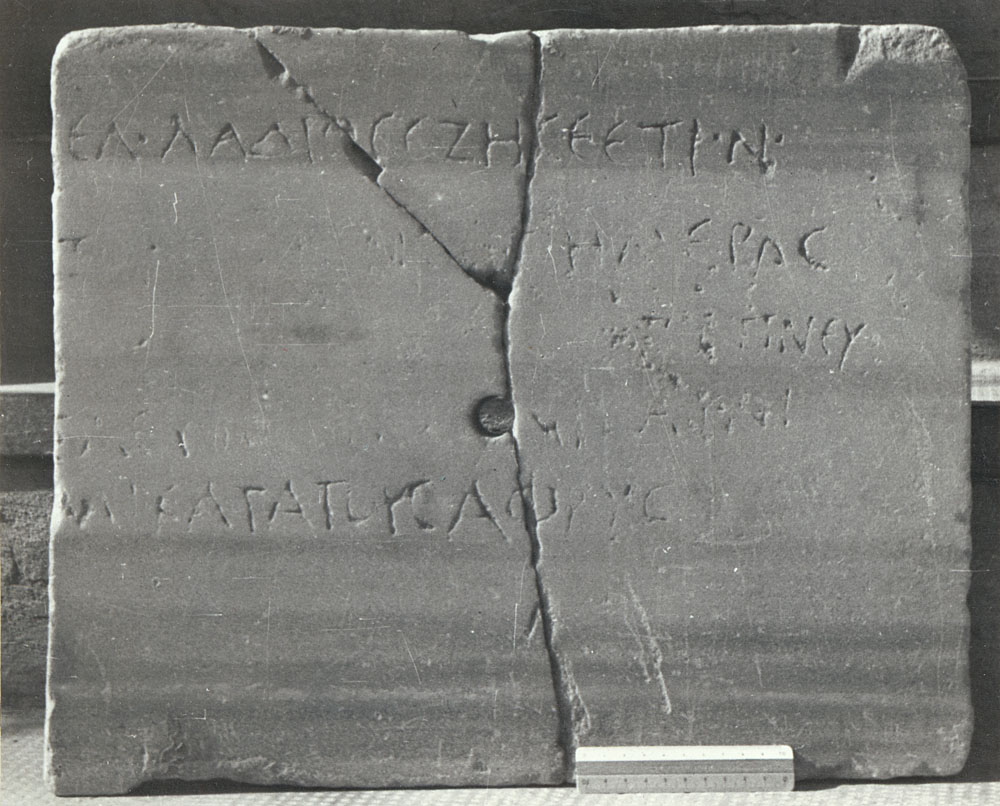

Az utolsó napon még két hasonló felépítésű szakasz volt. Az első ismét nagyon vegyesre sikerült (nem is tudom, hogy mi lehetett az elődások egymás mellé helyezésének a koncepciója). Van itt a Google régi helynevek kutatásában történő felhasználását bemutatótól kezdve az Image Markup Tool fejlesztését bemutatón át a régészeti adatbázisfejlesztésig minden. A digitális papirológiával foglalkozó panel azért elég izgalmas lehetett. Na jó, azért a koreai sajtókorpuszt bemutató előadás is érdekelt volna azért.

Ami számomra igazán érdekes volt az egészben, az az, hogy eléggé feltűnt a konferencia összképéhez viszonyítva a hazai helyzet különbözősége. Nálunk egyes területeket igen sikeresen művelnek (elsősorban a korpusznyelvészetre, a nyelvtechnológiára és a számítógépes nyelvészetre gondolok), míg mások gyakorlatilag még meg sem honosodtak (pl. kifejezetten DH-s megközelítésű történelemtudományi kutatásról nem tudok). A másik nagy különbség pedig szerintem a DH tudományszociológiai helyzete. Nálunk nagyon hiányzik a DH-s szemléletű kutatók közötti élénkebb kommunikáció, sőt: akár az együttműködés. Biztos vagyok benne, hogy borzasztó sokat tanulhat egymástól egy ilyen konferencián pl. a digitális filológus és történész. Tehát arra lenne szükség, hogy tudatosan vállaljuk, hogy igenis DH-s kutatómunkát végzünk, és cseréljünk eszmét a más területeken működő DH-sokkal. Lehet, hogy egy hazai DH-konferenciával kellene kezdeni.

Legújabb hozzászólások